Au milieu du battage médiatique croissant autour des agents de l’IA, un ingénieur expérimenté a apporté une perspective fondée sur la façon dont les travaux sur plus d’une douzaine de systèmes au niveau de la production couvrant le développement, les DevOps et les opérations de données. From his vantage point, the notion that 2025 will bring truly autonomous workforce-transforming agents looks increasingly unrealistic.

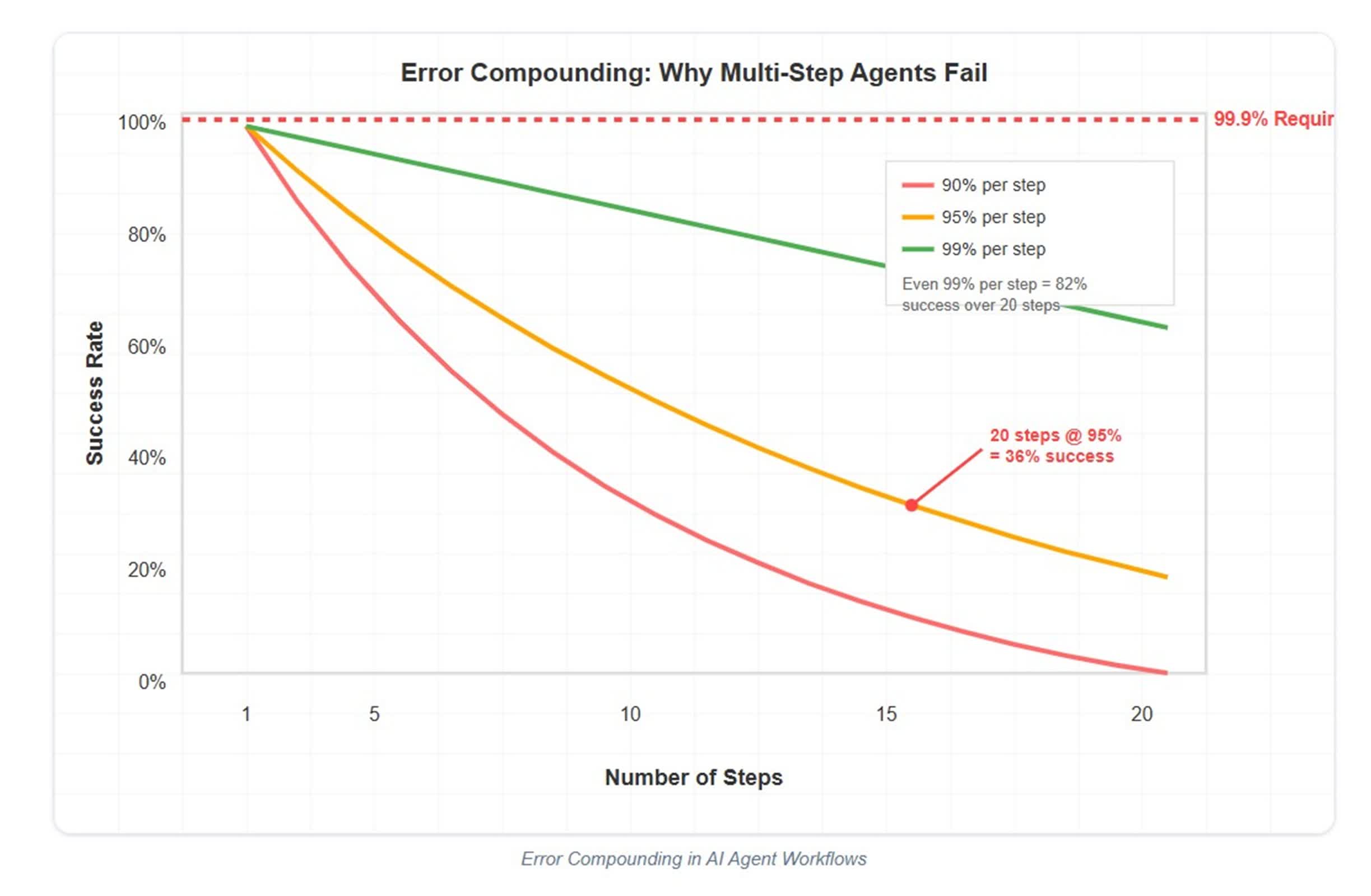

Dans un article de blog récent, l’ingénieur des systèmes Utkarsh Kanwat pointe vers des contraintes mathématiques fondamentales qui remettent en question la notion de workflows d’agent en plusieurs étapes entièrement autonomes. Since production-grade systems require upwards of 99.9 percent reliability, the math quickly makes extended autonomous workflows unfeasible.

« Si chaque étape d’un flux de travail d’agent a une fiabilité de 95%, ce qui est optimiste pour les LLM actuels, cinq étapes donnent un succès de 77%, 10 étapes 59% et 20 étapes seulement 36% », a expliqué Kanwat.

L’agent DevOps de Kanwat évite le problème d’erreur composé en divisant les flux de travail en 3 à 5 étapes discrètes et indépendamment vérifiables, chacune avec des points de retour explicites et des portes de confirmation humaine. Cette approche de conception – mettant l’accent sur les contextes limités, les opérations atomiques et l’intervention humaine facultative à des moments critiques – constitue le fondement de chaque système d’agent fiable qu’il a construit. He warns that attempting to chain too many autonomous steps inevitably leads to failure due to compounded error rates.

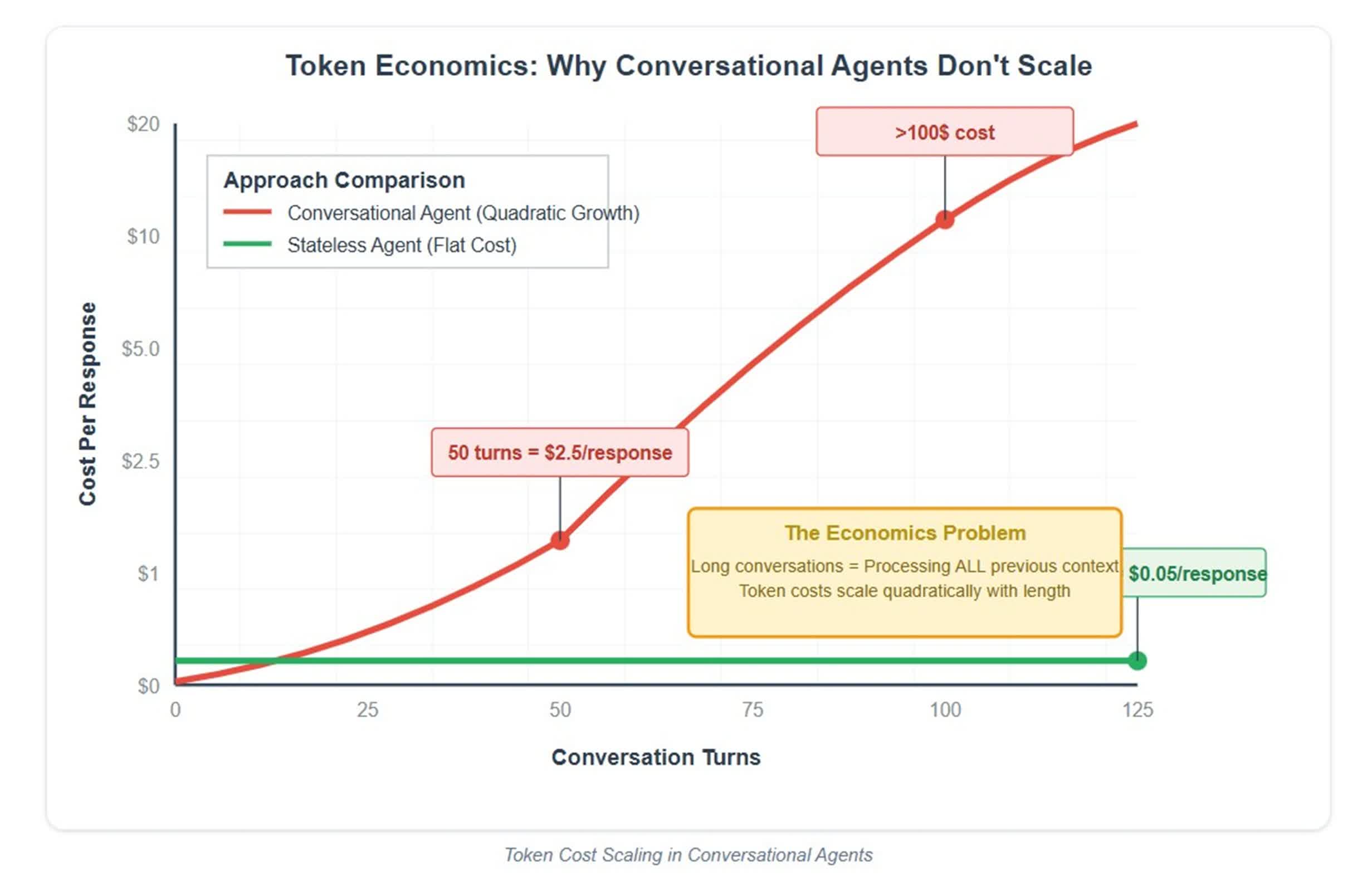

Token cost scaling in conversational agents presents a second, often overlooked barrier. Kanwat l’illustre grâce à son expérience en prototypant un agent de base de données conversationnel, où chaque nouvelle interaction a dû traiter le contexte précédent complet – provoquant la mise à l’échelle des coûts de jeton avec la longueur de la conversation.

In one case, a 100-turn exchange cost between $50 and $100 in tokens alone, making widespread use economically unsustainable. L’agent de génération de fonctions de Kanwat a contourné le problème en restant sans état: description, en fonction – pas de contexte à maintenir, pas de conversation à suivre et pas de coûts de fuite.

Beyond the mathematical constraints lies a deeper engineering challenge: tool design. Kanwat argues this aspect is often underestimated amid the broader hype around agents. Bien que l’invocation des outils soit devenue relativement précise, il dit que la véritable difficulté réside dans la conception d’outils qui fournissent une rétroaction structurée et exploitable sans écraser la fenêtre de contexte limité de l’agent.

Par exemple, un outil de base de données bien conçu devrait résumer les résultats dans un format compact et digestible – indiquant qu’une requête a réussi, a renvoyé 10 000 résultats et afficher une poignée – plutôt que de submerger l’agent avec une sortie brute. Handling partial success, recovery from failure, and managing interdependent operations further increases the engineering complexity.

« Mon agent de base de données fonctionne non pas parce que les appels d’outils ne sont pas fiables », dit Kanwat, « mais parce que j’ai passé des semaines à concevoir des outils qui communiquent efficacement avec l’IA. »

Kanwat critique les entreprises qui promeuvent des solutions simplistes « connectent simplement vos API », affirmant qu’elles conçoivent souvent des outils pour l’homme plutôt que pour les systèmes d’IA. En conséquence, les agents peuvent être en mesure d’appeler les API, mais ils ne parviennent souvent pas à gérer de vrais workflows en raison d’un manque de communication structurée et de conscience contextuelle.

Kanwat notes that enterprise environments seldom provide clean APIs for AI agents. Legacy constraints, fluctuating rate limits, and strict compliance requirements all pose significant hurdles. Son agent de base de données, par exemple, intègre des fonctionnalités d’ingénierie traditionnelles telles que la mise en commun de la connexion, les retournements de transaction, les délais d’attente de requête et la journalisation de l’audit détaillée – des éléments qui tombent loin de la portée de l’IA.

Les agents réussis de Kanwat partagent une approche commune: l’IA gère la complexité dans les limites claires, tandis que les humains ou les systèmes déterministes garantissent le contrôle et la fiabilité. His UI generation agent creates React components but requires human review before deployment. DevOps automation produces Terraform code that undergoes review, version control, and rollback. L’agent CI / CD comprend des critères de réussite définis et des procédures de recul, et l’agent de base de données confirme les commandes destructrices avant l’exécution. This design lets AI handle the « hard parts » while preserving human oversight and traditional engineering to maintain safety and correctness.

Pour l’avenir, Kanwat prédit que les startups soutenues par une entreprise chassant les agents entièrement autonomes auront du mal en raison de contraintes économiques et d’erreurs d’accumulation. Meanwhile, enterprises attempting to integrate AI with legacy software will face adoption hurdles because of complex integration issues. Il pense que les équipes les plus prospères se concentreront sur la création d’outils spécialisés et axés sur le domaine qui appliquent l’IA à des tâches complexes mais conservent une surveillance humaine ou des limites opérationnelles strictes. Kanwat prévient également que de nombreuses entreprises seront confrontées à une courbe d’apprentissage abrupte passant de démonstrations impressionnantes aux produits fiables prêts pour le marché.